Frimis 2012, reflektioner

VD Torbjörn Sjöström presenterar sina reflektioner kring årets branschmöte i Linköping: frimis 2012

Onsdag 10 oktober var det återigen dags för det årliga Frimisseminariet i Linköping

De flesta har säkert inte hört talas om detta, men det är ett seminarium för undersökare, som statades av Gösta Forsman tidigare på professor på Linköpings universitet med syfte att sammanföra undersökningsföretag med forskarvärlden. Första Frimis skedde 1995.

I år var det stort fokus på webpaneler, så här skrevs det i inbjudan:

Förmiddagens tema blir webbpaneler som vi belyser från tre utgångspunkter.

Webbpaneler har hittills inte kommit till användning inom den officiella statistiken. Vid Statistiska Centralbyrån har man länge varit avvaktande på grund av metodproblemen. Det finns tecken på att SCB nu håller på att ändra inställning, vilket skulle innebära ett slags genombrott för metodiken. Jörgen Svensson vid SCB:s processavdelning i Örebro har utrett frågan vid SCB.

Surveyföreningens webbpanelkommitté har under de senaste tre åren arbetat med en skrift om lämpliga mått för kvalitetsbedömning av webbpaneler och webbpanelundersökningar. Vid seminariet kommer kommitténs rapport – en remissversion – att släppas. Kommitténs ledamöter är på plats för att presentera rapporten.

Vid Novus har man jämfört resultat från undersökningar med webbpaneler (med olika rekryteringssätt) med motsvarande resultat telefonundersökningar för en rad variabler och funnit tydliga skillnader mellan olika upplägg. Torbjörn Sjöström och Mikael Ohlsson kommer och berättar om de senaste studierna.

Sammanfattningsvis så blev jag förvånad över hur teoritisk SCB och Surveyföreningens presentationer var. SCB har inte gjort några studier utan fokuserade enbart på vilka problem de tror sig stöta på om de någon gång i framtiden skulle jobba med webpaneler, många relativt uppenbara andra kanske mer teoretiska. De har fått en önskan från vetenskapsakademien att undersöka detta och kommer ev att göra någon mindre studie under hösten.

Surveyföreningens presentation var väldigt akademisk och teoretisk, inte helt enkelt att tränga igenom, de gav idéer på nyckeltal som man borde kunna mäta, men inte några tolkningar om hur de sedan skall läsas, vad är ett bra/dåligt värde osv.

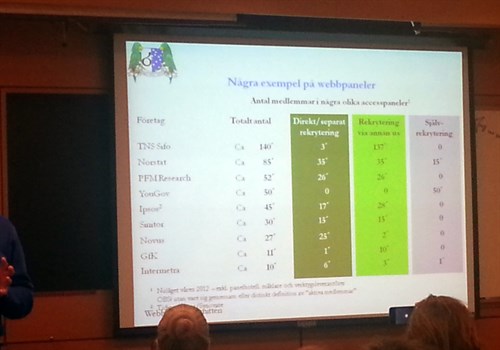

Men det kom fram ett par intressanta saker, Åke Wissing visade bild på hur olika leverantörers paneler var uppbyggda:

Tyvärr är det lite svårt att läsa på bilden här kommer en tabellversion på densamma:

| Företag | Totalt antal | Direkt/separat rekrytering | Rekrytering via annan undersökning | Självrekrytering |

| TNS Sifo | 140′ | 3′ | 137′ | 0 |

| Norstat | 85′ | 35′ | 35′ | 15′ |

| PFM Research | 52′ | 26′ | 26′ | 0 |

| YouGov | 50′ | 0 | 0 | 50′ |

| Ipsos | 45′ | 17′ | 28′ | 0 |

| Sinitor | 30′ | 15′ | 15′ | 0 |

| Novus | 27′ | 25′ | 2′ | 0 |

| GFK | 11′ | 1′ | 10′ | 0 |

| Intermera | 10′ | 6′ | 3′ | 1′ |

Åke sammanfattar denna bild med att alla utom en lätt kunde presentera hur deras panel var uppbyggd. Lars Björkman från YouGov bryter då in och hävdar att deras siffra inte stämmer och det blir en relativt osammanhängande diskussion. Men det som framkommer där är att Yougov Sverige inte kunnat ge ett svar på frågan hur deras panel ser ut och varifrån den är rekryterad, den siffra som Wissing fått till slut kommer från Yougovs marknadschef i Danmark.

(f.ö. är det YouGov Danmark som administrerar hela Yougovs panel i sverige, så dom borde ju veta)

Som helhet så går rapporten ut på att man bör kunna svara på ett antal kritiska frågor, de viktigaste är:

- Hur är panelen uppbyggd, är den slumpmässigt eller självrekryterad

- Vad är det för deltagarfrekvens, hur många är tillfrågade och hur många har svarat

- Hur många frågor ställer man till sin panel

Hela deras rapport finns att ladda ned här:

www.s-o-k.org/documents/rapport_webbpanelkommitten_remissversion.pdf

Sedan kommer vi till min presentation.

Min presentation finns att ladda ned här

Jag fokuserar mer på praktiska exempel.

Som första exempel så tittar jag på Facebookundersökningen från Göteborgs universitet. Denna rönte mycket uppmärksamhet när den publicerades delvis för att det var intressant men också för att det framkom ett par uppseendeväckande resultat tex att 30% av alla kvinnor var olyckliga om de inte loggade in på Facebook. Vi genomförde därför exakt samma mätning hos oss och kom fram till mycket rimligare siffror. Värt att notera är att vi ställde exakt samma frågor för att kunna jämföra med deras resultat, men ex att fråga någon hur länge man är inne på en viss sida så är det en stor risk att respondenten överdriver sitt svar. Som referens, de flesta tror att man i genomsnitt talar ca 5 minuter i telefon per samtal, den faktiska siffran är 1,5 minut. Så man skall ta tidsuppskattningar med en nypa salt. Men då frågorna är ställda på exakt samma sätt så är resultaten jämförbara.

Jag visade också på en undersökning som Skatteverket presenterade innan sommaren. Där de kom fram till att endast 6% tycker det är ok att tjäna pengar svart. Vilket jag reagerade på att det är en väldigt låg siffra. Det jag upptäcker att ett par hundra sidor in i rapporten finns en demoskopstudie som visar något helt annat. Enligt den studien så är det ca 32% som skulle arbeta svart om det visste att de kunde komma undan med det. Det låter som en mycket rimligare siffra.

Hur kan det vara så stora skillnader då?

Jo den första siffran kommer från Skatteverkets postala enkät, med en lång rad frågor kring hur man ser på skattesystemet och liknande. Troligtvis så framgår det tydligt att avsändaren är skatteverket.

Jag vet inte många som skulle på en direkt fråga från skatteverket svara ärligt på deras vilja att arbeta svart, man frågade också om man hade arbetat svart någon gång Även om man blir garanterad anonymitet så ställer avsändaren till det. I demoskopfrågan så är frågeställaren en neutral part där det inte finns någon koppling till skatteverket, vilket borgar för att respondenten är mycket mer ärlig i sitt svar.

Men utöver det så presenterade jag en sammanfattning av vår parallellstudie.

Vår rapport om parallellstudien kan läsas här:

/media/6065/novus_parallellstudie.pdf

I den ser vi stora skillnader i hur dessa paneler sköts samt att det finns skillnader i beteende hos medlemmar i slumpmässigt och självrekryterade paneler.

Novus har enbart slumpmässigt rekryterade panelmedlemmar. Man kan inte begära att få vara med i en panel utan man måste bli utvald. Urvalsprocessen går till så att vi slumpmässigt väljer ut personer som vi sedan frågar om de vill vara med i vår panel.

I en självrekryterad panel så kan vem som helst anmäla sitt intresse, antingen genom att klicka på en sponsrad länk i tex Google, eller genom att man är med i en idrottsklubb/förening/kundklubb. Dessa paneler lockar oftast med stora ersättningar, vinster eller liknande för att få så många medlemmar som möjligt.

Men då det är en grupp som aktivt söker sig till paneler så ser man också att det är en helt annan typ av drivkrafter. Dessa drivs av två saker som inte syns i slumpmässigt rekryterade paneler: Belöning och tidsfördriv.

Dessa två egenskaper kräver regelbunden stimulans. Att få en belöning på några kronor en gång i månaden räcker inte. Man måste få svara på många undersökningar, annars är det inte värt det. Detsamma gäller tidsfördriv.

Det vi ser är att de medlemmar som är med i självrekryterade paneler svarar på många fler undersökningar. Upp till 20 stycken i månaden är tyvärr inte ovanligt. Får man så många undersökningar så sjunker deltagarfrekvensen drastiskt, vi ser siffror ned på 25%, en av deltagarna i parallellstudien kunde inte ens uppge vilken deltagarfrekvens de har.

Svarar man på många undersökningar där belöningen är ett uttalat mål så sjunker också nogrannheten och man vill slutföra undersökningen så snabbt som möjligt. På vår undersökning som var konstruerad att ta 5 minuter, så svarade de som var med i en självrekryterad panel 50 sekunder snabbare än de som var med i de slumpmässigt rekryterade panelerna. Det tyder på att man inte läser frågan lika noggrant och då ej heller reflekterar tillräckligt mycket över svaret. Risken för slarvfel är uppenbar.

Låg deltagarfrekvens innebär att det ökar risken att vissa grupper får ett orimligt genomslag i mätningarna. Jag tog upp det i en debattartikel som presenterades i DN i januari i år tillsammans med Jenny Madestam. Där tog vi upp det faktum att SD och andra grupper som drivs av en stark övertygelse är överrepresenterade i självrekryterade paneler.

Hela artikeln finns att läsa här:

http://www.dn.se/debatt/daliga-undersokningar-ger-uppseendevackande-resultat

Jag kunde också presentera helt nya siffror från en ny studie som Göteborgs universitet håller i. Tyvärr är det lite för få frågor och det hela kretsar kring folks uppfattning kring vägtullar i Göteborg. I grunden en ja/nej fråga. En ja/nej fråga är per definition väldigt begränsande och man missar nyanser i värderingar hos respondenterna. DEt blir då också ett grunt underlag för att se skillnader i åsikter. Dock så ställdes frågan också som svarsskala från 1-7, då får man lite mer möjligheter att jämföra olika paneler och om det finns några förskjutningar i åsikter mellan de olika urvalen.

Det vi här är samma som i vår egna parallellstudie, att medlemmar i självrekryterade paneler är mer kritiska, ger man dem en möjlighet att svara på en skala så är de mer i den negativa ytterkanten på skalan.

Vad som också är uppseendeväckande i studien är att YouGov inte kunde presentera vilken deltagarfrekvens som de hade i sin undersökning. Detta bör man kunna enligt ESOMAR men också enligt webpanelkommitténs preliminära rapport. Även konstigt att SIFO endast hade 38% deltagarfrekvens, en förvånansvärt låg siffra, nu kan det vara så att jag har fått fel information och att någon har skrivit fel, men stämmer det är det oroväckande. Det var också så att SIFO hade för få ungdomar bland sina respondenter utifrån hur åldersfördelningen ser ut i målgruppen.

Torbjörn Sjöström

VD

Novus